ニュースな科学

AIのリスク抑え暴走防ぐ

OECDが開発・運用指針

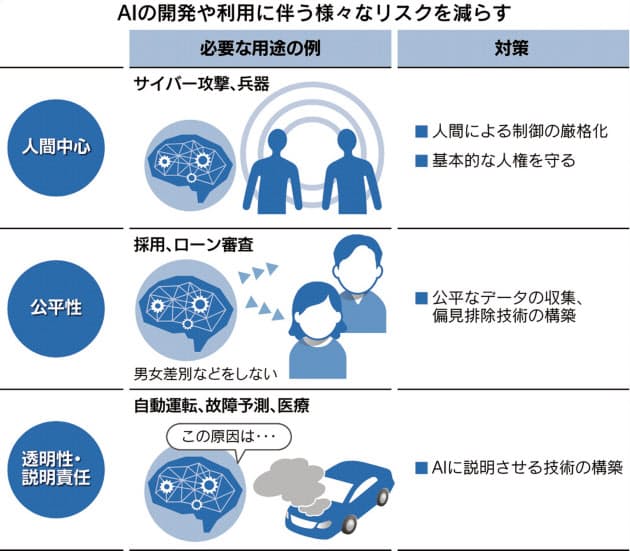

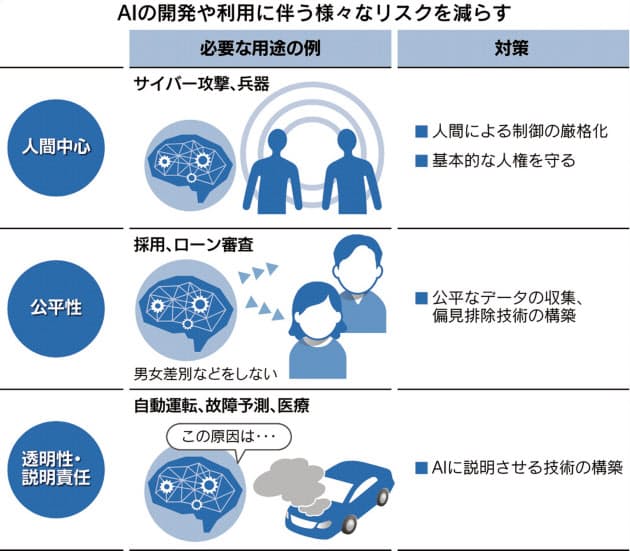

経済協力開発機構(OECD)が5月、人工知能(AI)の開発や運用に関する基本指針を採択した。人にとって本当に役立つかを前提に考える「人間中心」のほか、差別をなくす「公平性」や説明責任など、AIの開発や利用にあたって重視すべき原則を打ち出した。AIは様々な分野で人の生活を便利にする技術として期待される一方、普及にはリスクもある。AIや開発する人の暴走を防ぐ防波堤の役割を担っている。

画像の拡大

指針には、日米欧などのOECDに加盟する36カ国に、ブラジルやアルゼンチンなどを加えた計42カ国が署名した。指針では大きく分けて「人間中心」「公平性」「透明性」などを求めた。OECDは夏にも原則を具体的なガイドラインに落とし込む。

策定に関わった中央大学国際情報学部長の平野晋さんは「AIの負の側面を最小限にし、信頼できるAIをつくっていく」ことが策定の目的と説明する。例えば、原子核物理の研究が原子爆弾を生みだしたように、科学技術の進歩には副作用がある。AIも同様で、負の側面を抑えるため、開発や利用に関する原則を示す必要があるわけだ。

AIの指針を設けるのは世界的な流れだ。日本政府や欧州連合(EU)はすでに同様の指針や原則を策定した。6月8日に開かれた20カ国・地域(G20)の貿易・デジタル経済相会合では、日本やOECDの指針などを受けて「リスクと懸念を最小化しながら、AIの恩恵を最大化し、共有する」とし「AIの責任ある利用に向けて協調する」との共同声明を採択した。

企業でも動きは進み、国内ではソニーや富士通、NEC、NTTデータ、海外では米マイクロソフト、米グーグル、米IBMなどが自社の指針などを公表している。これらの指針などが注目するAIの普及に向けた課題はおおよそ同じだ。

OECDが指針で示した「人間中心」とは、AIに対する人の不安を抑えるためのものだ。AIが人の知能を超えるシンギュラリティー(技術的特異点)が到来するとの予想などもあり、人の仕事を奪うといった不安は根強い。そこで、基本的な人権などを阻害しないという原則を掲げた。平野さんは「AIがいかに高度になっても、あくまで道具として制御できなければならない」と話す。

「公平性」とはAIの判断によって差別が生じないことなどを求めたものだ。筑波大学教授の佐久間淳さんは「採用やローンの与信といった意思決定をAIがする際に公平性が必要」と強調する。

例えば米ハーバード大学が13年に発表した研究では、グーグルの検索サイトで白人系の名前よりも黒人系の名前を検索した方が、犯罪歴チェックの広告が多く表示されたという。18年には米アマゾン・ドット・コムが開発した人材採用のAIが女性よりも男性を優遇することが明らかになり、停止に追い込まれた。

AIは一般に、学習したデータに沿って判断するようになる。偏見を含んだデータを学べば、偏見に基づいた判断をするAIになる。こうした偏見を新技術などで取り除く必要があるわけだ。

「透明性」とは、AIが下した判断の理由を説明できることなどを指す。例えば、AIの主流の技術である「深層学習」は、過去のデータをもとに判断項目をAI自身が決める仕組みのため、人には判断理由が分からない「ブラックボックス」になりやすい。説明責任を果たせるように透明性が求められている。

例えば自動運転車が事故を起こした場合、どのような判断が運転ミスを引き起こしたのか分からなければ、再発防止につながらない。AIで工場の故障の予兆を検知する場合も、検知した理由を説明できないと、人が修理の判断に迷う。

こうした透明性を新技術で確保する取り組みが進む。1月には公平性と透明性、説明責任に特化したAI学会が米国で開催された。40件の発表のうち、約6割が公平性に関するもので、透明性や説明責任はそれぞれ5%以下と、まだ緒に就いたばかりだ。

指針について、富士通デジタルテクノロジー推進法務室室長の荒堀淳一さんは「AIが注目される前から生じている問題がAIによって顕在化した」と指摘する。AIを通じて使いこなす人の倫理が試されている。

■シンギュラリティー

人工知能(AI)が人の知性を超える転換点のことを指す。米国の未来学者、レイ・カーツワイル氏が2045年にその時期が到来すると予想して注目を集めた。人が自分より賢いAIを作ることができれば、そのAIはさらに賢いAIを作れるようになり、これを繰り返すとAIが加速度的に進化し、経済や社会が大きく変化するという。

囲碁や将棋でAIは人を上回った。これは一部の機能で人を超えたにすぎず、人の制御や管理が可能だ。一方、人間の知能を上回る汎用的なAIが実現した場合、人の制御が行き届かず、人間中心の概念が脅かされるとの懸念がある。