人工知能の光と影㊤

日米欧、倫理問題対応急ぐ

西田 豊明 京都大学教授

。制御可能性や自律兵器開発に懸念広がる

。AI登場で人間の統治が行き届かぬ恐れ

。社会の支持獲得へ倫理問題の議論公開を

人工知能(AI)は「第4次産業革命」といわれる革新的な社会サービス基盤をけん引する原動力として脚光を浴びている。その半面、AIの負の側面としてこれまで様々な懸念が表明されてきたりそのいくつかを紹介しよう。

第1に、AIの安全性と制御可能性の問題だ。現在のAI技術の中心となる大量のデータからの統計学習手法が、多様で予測困難な現実世界のあらゆる状況で適切に動作するという保証はまだ得られていない。

またAIが暴走して、人間の管理能力を超えた事態を引き起こすのではないかとの不安を払拭できない。自動運転車、オートパイロット搭載車の事故が続くなど、AIが安全面で未完成であることを示唆する兆候も表れている。

第2に、AIによる日常生活のリスク増加の問題だ。情報収集のための圧倒的な質・量のセンサーネットワークとAI技術を用いたデータの自動解析技術の広がりにより、プライバシーやセキュリティーなど日常社会生活に不可欠な権利保護が破綻するのではないかという不安がある。

物質・エネルギーによりわれわれの住む物理世界に作用する従来技術と異なり、AIは情報を通じて人間自身の心的世界に作用する。このため客観的にとらえたり、人間社会から切り離して実験したりすることを困難にしている。

第3に、AIによる失業の問題だ。これまで人間が手掛けてきた高度に専門的な仕事を多くをAI技術で、より高品質に、高速に、低価格に実現できるので、大規模な失業が生じるのではないかとの懸念が広く表明されている。

第4に、自律兵器の開発の問題だ。AI技術を使って、道徳的責任能力のある人間の介入なしに自律的に攻撃目標を定め、人々を殺傷に至らしめてしまう兵器が開発されるのではないかという懸念がある。情報化社会では、インターネットからAIツールを入手して、手元のコンピューターで簡単に実行できるので、こうした自律兵器の開発を防ぐの僧非常に困難である。

第5に、AIによる人間社会の衰退の問題だ。AIの進展により、人類が培ってきた人間力や社会力が衰退するのではないかという恐れも表明されている。

こうした懸念は、具体的な事故や惨事に起因する問題意識というよりも、現在起きつつある急速な変化を示す種々の兆候から年じた不実という色彩が濃い。

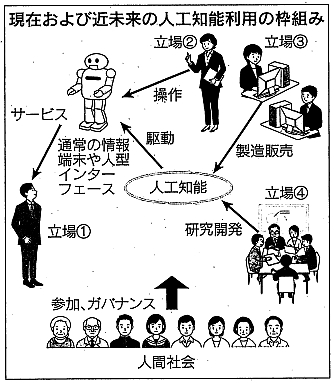

その不安の背後にある構造を、図に従って整理してみよう。通常の市民の立ち位置を①とする。立場①の人が接するのは通常の情報端末、あるいはロボットやコンピューターグラフィックスで実現された「人型インターフェース(接点)」である。その背後にはAI、場合によっては立場②の人が加わる。その奥にはAIの製造販売をする立場③の人、さらにAIの研究開発をする立場④の人がいる。

これらのプロセスは社会の構成員の参加により稼働し、プロセスの細部に至るまで社会によるガバナンス(統治)のもとに置かれていることが社会規範となっていた。

AIの倫理的側面が問題になるのは、AIが急速に高度化して、掌握しきれなくなったときである。この図式の至るところで、従来の想定を超えた事態が起きてしまう。

①の立場の人が通常の情報端末あるいは人型インターフェースを通して接する「相手」が、普通の人間のレベルをはるかに上回る知力を持つAIになると、①の立場の人は安全性や悪用に関して弱い立場に追い込まれてしまう。

②の立場でサービスを提供する人にとっては、自分が掌握しきれないAIに任せた業務(例えば運転)で生じた損失や責任を引き受けねばならなくなる。③の立場の人も同様で、製造者としての責任を果たしきれなくなる。④の立場の人については、社会問題を引き起こした道義的責任が問われることになる。他方、社会にとっても、AIを使ったサービスが適切に提供されるようガバナンスを維持することが困難になる。

様々な可能性視野に議論

こうした事態を受けて2005年ごろより、AIの研究開発およびそれを統括する経営者・政府機関の側から、AIの健全で有益な発展の方向を促すための具体的な取り組みが開始された。

AI技術が図の枠組みでとらえられる中短期的な視野に立てば、まず②~④の立場の人に一定の職業倫理に従うことを求める必要がある。さらに、社会全体がリテラシー(知識)を共有するよう啓蒙するアプローチと、安全性や制御可能性を中心とする依拠可能なAIの設計開発技術の確立を目指したアプローチを併用することが第一歩となる。

職業倫理の制定に関しては日本の人工知能学会が14年に立ち上げた倫理委員会が今年6月、誠実性や説明責任など、AI研究開発者があまねく順守すべき事項を示した倫理綱領案を公開した。

一方、米ボランティア団体FLI(Future of Life Institute)は15年に、オ―プンレター(公開書簡)という方法をとり、世界中のAI研究開発者に具体的な項目を挙げて、倫理を考慮した研究開発をすることを呼びかけた。負の側面に配慮しつつ、人間社会に有益なAIを開発すべきだという声明には、8千人超が署名した。さらに自律兵器開発反対の声明には2万人超が署名した。その後、頑健で有益なAI研究推進に資する研究提案を募集し、37件に研究資金を提供した。

欧州では、AIを搭載する可能性の高いロボットに道徳判断機能を持たせるべきではないという考え方が強い。英工学物理研究会議(EPSRC=Enginering and Physocal Sciences Reaarch Council)は、ロボットの研究開発と適用を手掛ける人間の責任の所在を明確化し、情動や意図を持つかのように振る舞って利用者の弱みに付け込んではいけないとする5原則を提案している。

長期的な側面への取り組みについては、米人工知能学会が08~09年に、AIが社会に与える影響を視野に入れて、今後100年間にわたるAIの健全で有益な研究開発に関する公的な議論を開始した。現在は米スタンフォード大学がホストとなり、常任委員会を設置して「AIlOO」として活動を継続している。

その検討項目は安全性、プライバシー、悪用、軍事、倫理、法だけではなく、人間とテクノロジーの共存、心の哲学、自由と民主主義など多岐にわたっている。AIの倫理的側面への取り組みは、日米の政府レベルのAI関連施策の取り組みの中でも取り上げられている。

長期的には、テクノロジーの進歩で図の枠組みは大きく変容し、社会状況も現在とはかなり異なったものになる可能性がある。このため従来の原理原則や知識だけに依拠することなく、原点に立ち返り、様々な可能性を視野に入れた広い議論が不可欠だ。

こうした議論が社会の支持を得るには、議論の公開が必要だ。今年開催された米政府主導の4回のワークショップでは、議論のビデオが公開配信されている。さらに公開された議論を活用するには、膨大な議論を公平かつタイムリーにまとめねばならない。大規模熟議の支援は非常に挑戦的な課題だが、これからの社会貢献のためにAI研究者が取り組むべき最重要課題として位置づける必要がある。

![]()

人工知能の光と影㊦

「人間の脳を超越」あり得ず

西垣 通 東京経済大学教授

。過去のAIブーム失敗の反省から始めよ

。深層学習でも調整作業に相当の手間必要

。AIよりもIA(人知の増幅器)をめざせ

囲碁の名人を米グーグルの人工知能(AI) 「アルファ碁」が破ったことで、AIに対する世間の期待は高まる一方だ。人間はチェスや将棋ではもう歯が立たない。組み合わせ数が膨大な囲碁は最後の牙城だったが、ついにこれも攻め落とされてしまった。

それだけではない。AIが大学人試問題を解く能力も年々上がっている。近々、外国語の翻訳もスマートフォンが自動的にしてくれるらしい。「コンピューターが人間より頭が良くなるのは、もう時間の問題だ」という確信に満ちた声も聞こえてくる。

だが、そうなると困ることもある。ホワイトカラーの仕事が奪われるかもしれない。やがて国内労働人口の約半分の仕事がAIに代替されるという調査報告も昨年発表された。未来のAI社会は一体、幸福なのか、不幸なのか…

言っておこう。こうした期待や心配は大きな誤解に基づいている。囲碁や将棋のAⅠソフトはすべて人間がつくったものだ。つまり普通の人間でもコンピューターの力を借りれば天才を負かせるというだけの話だ。百科事典を丸ごと記憶しているコンピューターが入試用の暗記問題を解いたところで驚くことはない。

とうの昔から、機械の能力は部分的には人間をしのいでいる。だが自動車とマラソンをして負けたからといって、騒ぐ人がいるだろうか。「頭が良い」とは本当はどういうことなのか、きちんと考えてみなければならない。

ただし、世間の大騒ぎにはそれなりの理由がある。2010年代後半に入って、AIが新たな産業革命を起こし、近未来社会を変えるという議論が専門家の間で急速に盛り上がってきた。

グーグル、米マイクロソフト、米IBMなどの企業は既に巨大な研究プロジェクトに着手している。日本でも今年4月に政府主導で人工知能技術戦略会議がつくられ、産官学一体となってAI研究を進めるという。そこでは膨大な経済効果が見込まれている。とはいえ成果を上げるためには欧米の後追いより、まず機械と人間の知に対する深い考察が不可欠ではないか。

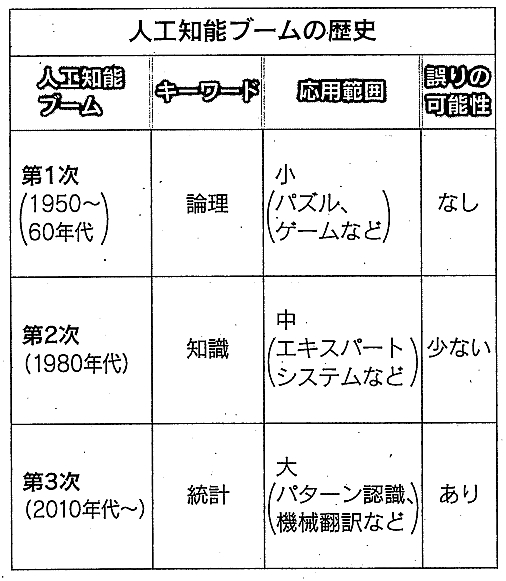

現在のAIブームは第3次だ(表参照)。第1次は1950年代、第2次は80年代で、ともに期待外れに終わった。とりわけ日本が80年代に開発した第5世代コンピューターは、500億円以上の予算をつぎ込んだあげく失敗したプロジェクトとして知られる。その反省から始めないと、同じ轍を踏むだろう。

コンピューターは論理機械だ。正確な論理操作をすれば、答えが誤ることはない。だからこそ優れた「人工の知能」に値するというのが第1次AIブームの時の発想だった。だが純粋な論理操作だけで解決できる問題は、簡単なゲームやパズルくらいしかない。

この挫折から、多くの「知識」をメモリーに蓄積しておき、それらを組み合わせて推論するという発想が出てきた。これが第2次AIブームだ。例えば医学知識をデータベースに貯蔵し、患者の検査データと組み合わせて病名を診断しようというわけだ。医者のような人間のエキスパートの代わりをAIが務めるので「エキスパートシステム」という名がついた。

この第2次AIブームはなぜ衰退したのか。知識の活用で応用範囲は広がったが、答えの精度が落ちる恐れが出てきたからだ。人間の知識は正確無比とは限らない。検査データと病名を結ぶ医学知識にも曖昧さはあり、だから誤診が生まれるのである。人間のエキスパートは何とか直観を働かせるが、AIには無理であり、そこに挫折を招く根本的問題があった。

日本の第5世代コンピューターの失敗の原因は、この難問から目をそむけ、ただ推論操作の高速化だけに取り組んだ点にあったのである。

第3次AIブームを起こしたのは「深層学習」という技術だ。画像や音声などのパターン認識は昔からコンピューターの苦手な分野だったが、深層学習はここに画期的なブレークスルー(技術突破)をもたらした。従来のパターン認識では通常、人間が外部から、パターンの特徴を機械に与える。だが深層学習を用いるAIは、自分で特徴を抽出してしまうのだ。

有名な「グーグルの猫認識」は、動画投稿サイト「ユーチューブ」の1千万の動画から自動的に猫の画像を取り出してみせた。さらに深層学習のプログラムは、脳神経に似た構造を持っている。こうして「人間の脳に近い機能を持つAIが誕生し、自分で概念を把握できる」という思い込みが生まれてしまったのだ。

専門家でもこうした思い込みを述べる者がいるが、これは完全な誤りだ。深層学習は優れた技術だが、あくまでパターン認識において有用であるにすぎない。実際に行っているのはビッグデータの統計処理であり、人間の脳における社会的・言語的な概念の処理と直接関係づけるのは困難だ。例えば自由とか国家といった概念を、統計処理のみから導き出すことなど不可能だろう。さらに統計処理はデータ群の全体的特性を抽出することはできるが、個別のケースでは間違える場合もある。

この点は重要だ。AIは論理的正確さが売り物だが、深層学習では誤りの可能性を排除できない。具体的にいうと、AIが描か犬か分からない奇妙な動物の画像を「認識」してしまう場合もある。深層学習の応用の現場では、AIが行った分類を、人間の概念分類に合致させるチューニング(調整)作業にかなりの手間がかかる。

以上のように、深層学習を駆使したAIは万能ではないし、決して何でもできる汎用機械ではない。アルファ碁ができるのは囲碁だけで、投資相談も無理だし、経済学の論文も書けない。にもかかわらず「近い将来、人間より賢い汎用AIが登場する」などと、自信たっぷりに述べる議論が出てくるのはなぜだろうか。

AIが2045年に人間の脳を上回るという「シンギュラリティー(技術的特異点)仮説」は、そうもた妄想の典型だ。これは米国の発明家レイ・カーツワイル氏が主張している仮説で、約30年後にコンピューターが自我を持ち、人間の代わりに知的作業をこなしてくれるという。一方、これは機械による人間の支配であり、阻止すべきだという論者もいる。

だがシンギュラリティー仮説や汎用AIなどは、西洋の宗教的伝統を背景とするものだ。神の論理は絶対であり、理想的なAIはそれに近づけるというわけだ。われわれ日本人が、そういう伝統に追従する必要はない。研究予算獲得のために欧米のまねをしても、大した成果は望めない。

機械知より生命知に強み

人間は論理機械でなく多細胞生物だ。だから人間の思考は論理矛盾を含んでいることも多いし、身体的な直観に支えられている。AIという機械知は過去のデータに基づくので、安定状態での作業効率は良くても、全く新しい環境条件には対応できない。生物は激変する地球環境の中で生き抜いてきた。この柔軟性こそ生命知の本質ではないか。

よって大切なのは、自我を持つ汎用AIといった幻を追わず、実用的な専用AIの精錬にまい進することだ。応用分野は自動運転、農業、スマート工場など数多い。目ざすべきはAIではなく、「IA」つまり人知(インテリジェンス)の増幅器(アンプリファイアー)なのである。